与 RT-1 模型的泛化能力相比,RT-2的目标是训练机器人从观测到动作的端到端模型,并且从大规模视觉-语言模型预训练模型中学习泛化知识。终,Google

提出一个在机器人轨迹数据和互联网J别的视觉语言任务联合微调视觉-语言模

型的学习方式。这类学习方法产生的模型被称为视觉-语言-动作(VLA)模型,具有

泛化到新对象的能力、解释命令的能力以及根据用户指令思维推理的能力。

RT-2 算法整体使用大规模预训练的视觉-语言模型结构,模型参数可以达到

55B 的参数量,远超 RT-1 的参数规模,同时利用大规模预训练视觉-语言模型模型中编码的丰富视觉问答知识来帮助具身模型的训练。RT-2 将输出的动作进行和

RT-1 相同的离散化操作后将词元加入视觉-语言模型原先的词表中,可以把动作

词元视为另外一种语言进行处理,无需改变原有视觉-语言模型结构设计。由于 RT-

2 已经在海量的视觉问答任务中进行预训练,在对图片和任务指令的理解上有更加丰富的经验,在任务集合上具有更强的泛化能力。

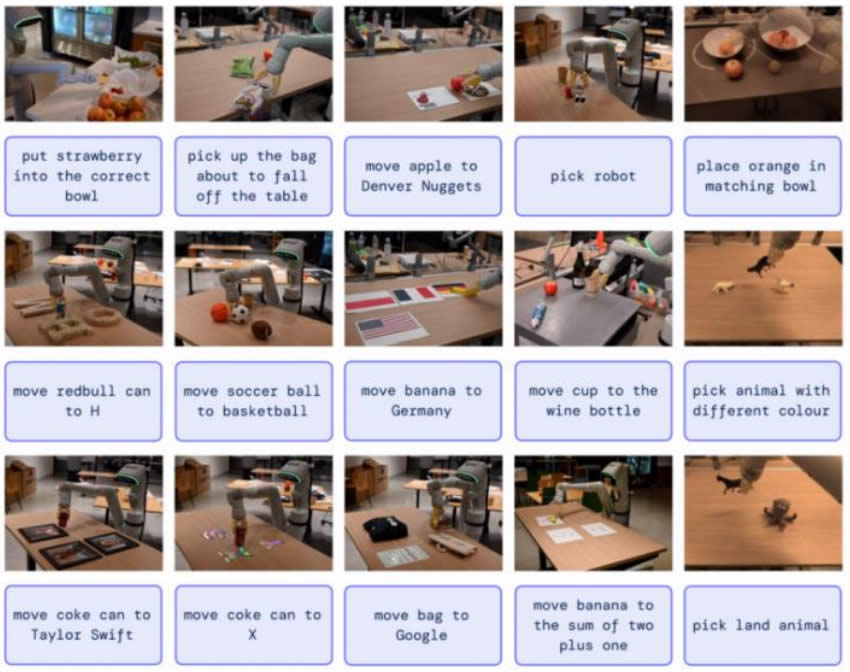

RT-2 能够运用其大规模预训练的视觉问答经验进行泛化,在现实世界的任务中进行推广,实现推理、理解和识别。例如在下图的拾取、移动、放置等具体任务

中,智能体能够准确识别任务需求并且以过往训练经验为基础准确地完成。

RT-2 能够推广到各种需要推理、符号理解和人类识别的现实世界情况

|