大语言模型可以实现流畅的文本生成、问题解决、创意写作以及代码生成,视

觉-语言模型(VLM)则能够实现开放词汇的视觉识别。以上能力对于现实环境中

的通用型机器人非常有用,然而它们如何获得这些能力还是未知。如何将大型预训

练的视觉-语言模型直接集成到低J机器人控制中,以促进泛化并实现紧急语义推

理,成为了机器人下一步发展的方向。

Google 提出的 RobotTransformer(RT)系列使用了更大规模的语言模型和更多的具身智能任务数据,在大量具身智能任务中获得较好效果。其中 RT-1 算法

使用预训练的 EfficientNet-B3 网络初始化,以机器人状态和历史图片作为输入,

通过 EfficientNet 特征提取后直接输出动作。

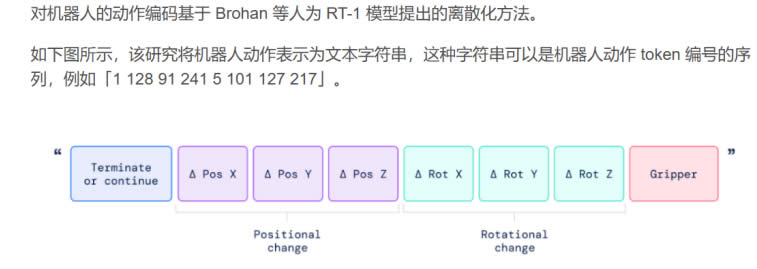

RT-1 将机器人动作的每个维度进行均匀离散化,并将动作词元化,然后使用

监督学习的损失进行训练。为了使视觉 - 语言模型能够控制机器人,还差对动作

控制这一步。该研究采用了非常简单的方法:他们将机器人动作表示为另一种语言,

即文本 token,并与 Web 规模的视觉-语言数据集一起进行训练。

机器人动作数字 token 化

RT-2在机器人任务上展示了更强的泛化能力,以及对超出其接触的机器人数据之外的语义和视觉的理解。RT-2 在 RoboticTransformer1(RT-1)的基础上进行,

直接训练视觉-语言模型以实现开放词汇视觉问答和视觉对话,输出低J机器人动作,同时解决其他互联网规模的视觉语⾔任务。相较于 RT-1,RT-2 模型在机器人

理解新任务,并通过执行基本推理来响应用户命令,例如推理物体类别或GJ描述

等方面具有更大的优势。

|